服务热线

- 电话 : 0510-85138995

- 手机 : 13196546681

- 联系人 : 张先生

- 企业QQ : 2275439036

- 邮箱 : 2275439036@qq.com

- 网址 : www.deburringmac.com

- 地址 : 江苏省无锡市滨湖区太湖大道2168号佳诚国际A座513

时间: 2025-06-29 07:53:55 | 作者: AG亚游九游會

2025 年初,作者觉得 AI 被过度炒作,ASIC 仍是小众产品,市场回调不可避免。笔者的长期观点发生了巨大变化。AI技术和应用正在以惊人的速度加速发展。GenAI/LLM*之一Nvidia将在2030年成为首家市值达到10万亿美元的公司。

大型语言模型(LLM)在功能和成本效率方面都在迅速提高。目前每周有超过5亿用户,其中ChatGPT*,而且这一个数字还在迅速增加。这种指数级增长推动了数据中心使用量和资本支出的大幅度的增加,主要由*的CSP推动——亚马逊、微软、谷歌、Meta和现在的OpenAI。其中四家是市值达万亿美元的公司。

在GTC 2025上,Nvidia首席执行官黄仁勋预测,到2028年全球数据中心的资本支出将达到1万亿美元。按照这一个速度,到2030年数据中心的资本支出可能达到约1.4万亿美元。

华尔街预计,从2024年到2027年,Nvidia的收入将翻一番,达到每年约2750亿美元。其中约90%用于数据中心;其中很大一部分是网络、软件和系统,而不单单是GPU。Nvidia不销售半导体。他们销售模块、电路板、机架和系统。如果Nvidia到2030年再增长50%,其年收入将超过4000亿美元,主要由数据中心需求推动。部分原因是GPU已经变得像智能手机一样。它们的每瓦性能提升如此之快,以至于仅用3到5年就可以更换它们,这是经济的。功率是数据中心的限制因素,因此每瓦性能比每美元性能更重要。

随着LLM的快速扩展,预计到2030年数据中心的半导体支出将超过5000亿美元,占整个半导体行业的50%以上。

几乎所有数据中心半导体收入都集中在九家公司身上:Nvidia、台积电、博通、三星、AMD、英特尔、美光、SK海力士和Marvell。一些市值不超过100亿美元的小公司在数据中心领域占有主体地位——Astera、Credo、MACOM、ASPEED、Alchip、GUC和SiTime。市值万亿美元的巨头(亚马逊、微软、谷歌、Meta、Nvidia和博通)可以收购AMD、英特尔、Marvell、联发科、Astera等小公司,以确保其在AI领域的领导地位。

按年计算,这一个市场的规模超过1500亿美元,预计到2030年将翻一番甚至更多,达到3000亿至4000亿美元。

目前,前四大CSP约占Nvidia销售额的一半。由于只有*的参与者才能构建高价值前沿LLM,这种销售集中度可能会持续下去。

Nvidia的*客户每年的支出已达到200亿美元,而且上涨的速度很快。虽然开发定制加速器每年可能要花费约5亿美元,但如果结果是针对内部工作负载优化的更便宜的加速器,那么这是具有成本效益的。Nvidia的利润率约为75%,Broadcom约为65%。如果他们都以25美元的成本制造相同的AI加速器,那么Nvidia的售价为100美元,而Broadcom的售价为75美元。因此,与Broadcom合作能节约25%。此外,GPU具有很强的可编程性。但正如Sam Altman所说,可以牺牲一些灵活性,比如只关注变压器,同时仍运行所需的工作负载。Alchip和Broadcom估计AI加速器的成本降低了约40%。

尽管如此,大型CSP仍将继续购买GPU以实现灵活性和风险管理。他们的大多数云客户的AI模型都使用PyTorch针对Nvidia GPU进行了优化。

Nvidia宣布了未来几年非常积极的GPU路线图,旨在超越定制AI加速器和AMD的竞争。

与此同时,如果AMD可成为Nvidia的替代GPU供应商,那么它就有巨大的机会。这是AMD进入万亿美元俱乐部的门票。首席执行官Lisa Su已经展示了后来居上的能力。LLM研发人员希望AMD取得成功,并将为他们提供具有竞争力的业务。但AMD面临挑战:Nvidia NVLink72具有扩展交换功能,而AMD没有。此外,Nvidia还将在未来几年内扩展到576个GPU。Nvidia CUDA经过十几年的发展,现在Dynamo又增添了该公司在软件方面的*地位。

假设CSP和OpenAI在2030年购买所有AI加速器的三分之二,将其需求分为定制ASIC和GPU,GPU支出可能达到2000亿美元至2700亿美元,大多数来源于Nvidia。定制AI加速器可能占1000亿美元至1300亿美元(博通首席执行官Hok Tan预计到2027年TAM将达到600亿美元至900亿美元)。这些数字可能还有上升空间。

参加AI加速器竞赛的关键要求包括:一个非常庞大的ASIC团队;高速模拟专业相关知识(PHY速度升至448GT/s);先进的2.5D/3D先进封装,以及财务实力丰沛雄厚,并能获得台积电尖端节点和封装技术。

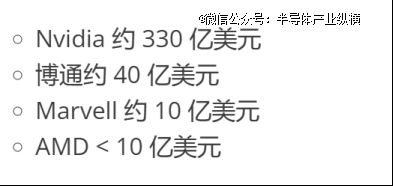

目前,博通占据定制ASIC市场约80%的份额,并且很可能继续保持50%以上的份额,因为它拥有团队、技能和资本,还可以将其ASIC与Nvidia以外*的交换芯片封装在一起。规模小得多的Marvell现在排名第二。AI ASIC的竞争者是联发科、Alchip和GUC。

CSP/OpenAI正在推动LLM和ASIC架构的发展。他们能够决定收购一家ASIC厂商,以进一步改善其成本结构。

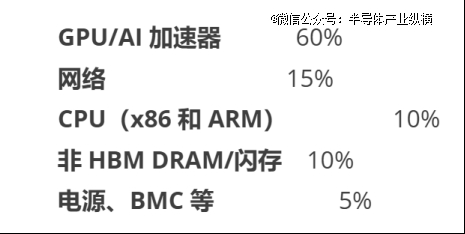

博通首席执行官Hok Tan估计,网络目前占数据中心支出的5%到10%,随着互连GPU数量的增加,互连的上涨的速度会更快,这一比例将增长到15%到20%。

Nvidia的扩展网络(例如,NVLink72,转移到NVLink576)提供了机架内和跨机架的无阻塞、全到全连接——一个强大的竞争护城河。

博通是一家强大的交换机芯片供应商,为非Nvidia系统提供替代方案。Marvell(通过收购Innovium)和Astera Labs(现已上市,市值约100亿美元)是新兴企业。Auradine等初创公司也在开发针对AI优化的交换机。

随着铜互连达到极限,光子学和激光将慢慢的变重要。该领域的主要参与者包括Coherent和Lumentum。

HBM收入(约250亿美元)完全来自数据中心。它比DDR提供更好的性能和集成度,尤其是对于AI工作负载。HBM以小芯片形式出售,对加速器效率至关重要。HBM利润率远高于DDR和闪存。

随着GPU功率超过1KW,电力传输变得逐渐重要。AI机架需要48V系统和复杂的PMIC。利润率适中,但市场规模巨大。

ASPEED主导着BMC市场,80%至90%的AI主板都采用了其芯片。该公司与富士康等OEM厂商关系紧密,拥有强大的竞争优势。

得益于先进的节点和2.5D/3D封装技术,台积电几乎为数据中心生产所有高价值非内存芯片。其一半以上的收入来自AI/HPC。

LLM正在推动AI数据中心基础设施的爆炸式增长,到2030年将占全球半导体市场的一半以上。这一增长将使一小部分公司受益——那些拥有规模、人才和资本来为超大规模CSP提供服务的公司。Nvidia、台积电、Broadcom和ASPEED凭借其强大的价值主张和可持续优势处于*位置。

AMD和英特尔正处于“泡沫之中”——如果他们能与Nvidia成为有力的竞争对手,他们就非常有可能加入万亿美元俱乐部;或者像英特尔一样,与台积电争夺AI代工业务。

那些无法快速扩张或通过合并实现规模的半导体公司可能会被市值万亿美元的巨头收购。或者,随着人工智能芯片慢慢的变多地由内部开发,它们可能会被淘汰。

上一篇:数据中心(机房)规划设计工程师2025详细报考流程

下一篇:2024年中国液冷服务器市场爆发:增长67%的巨大潜力